La inteligencia artificial está destinada a revolucionar el mundo, o eso es lo que las grandes compañías tras su desarrollo no paran de repetir. Uno de los grandes proyectos basados en esta tecnología es ChatGPT, el bot conversacional creado por OpenAI, que no ha parado de mejorar desde su lanzamiento, a finales de 2022. Hace unos días, puso a disposición de los usuarios de forma totalmente gratuita su nuevo modelo, llamado o3-mini.

Si bien el potencial de ChatGPT es enorme, esta tecnología también tiene sus inconvenientes. Uno de los principales es su alto consumo de recursos. Requiere de grandes cantidades de agua para su funcionamiento, lo que es insostenible con el medio ambiente. Se estima un coste aproximado de 519 mililitros por elaborar un texto de 100 palabras.

Microsoft es consciente del problema, y por eso ya ha modificado el diseño de sus nuevos centros de datos para no necesitarla. O, al menos, reutilizarla de forma eficiente. Aunque OpenAI también tendría que tomar cartas al respecto, parece ser que ChatGPT no tendría un consumo tan grande como se pensaba en un principio.

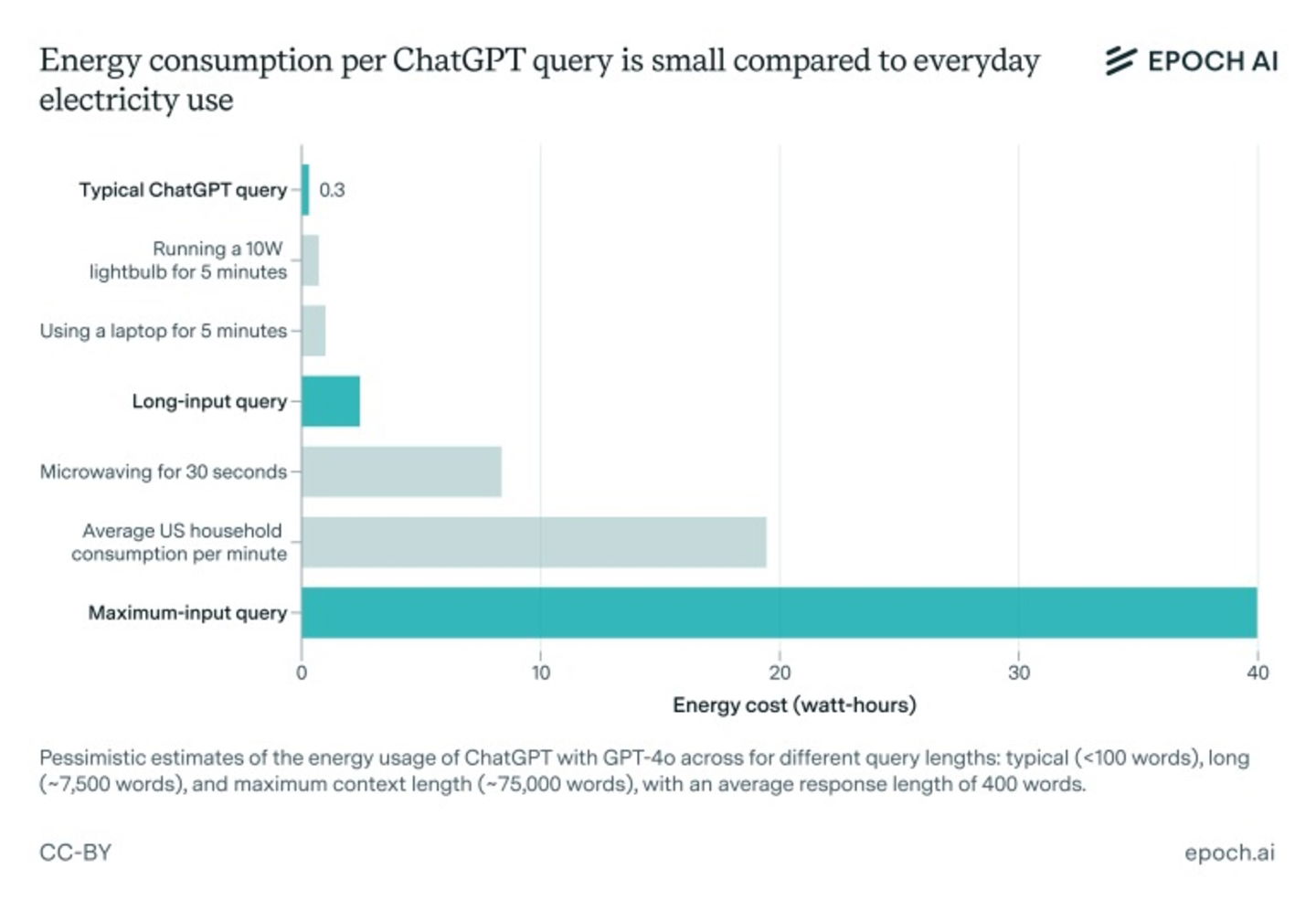

La consulta promedio de ChatGPT consume alrededor de 0,3 vatios-hora

El consumo energético de ChatGPT por petición es pequeño comparado con el uso diario de electricidad

Epoch AI es una organización de investigación sin fines de lucro fundada en 2022 por Jaime Sevilla, cuyo objetivo es analizar tendencias históricas en inteligencia artificial, y utilizar los análisis para prever y dar forma al desarrollo de dicha tecnología.

Un reciente análisis de Epoch AI ha calculado cuánta energía consume una consulta típica de ChatGPT. Con frecuencia, se presume que el bot conversacional de OpenAI requiere alrededor de 3 vatios-hora de energía para responder una sola pregunta, o 10 veces más que una búsqueda en Google.

Sin embargo, la conclusión de Epoch AI apunta a que es una sobreestimación. Utilizando como referencia GPT-4o, la consulta promedio de ChatGPT consume alrededor de 0,3 vatios-hora, mucho menos que bastantes electrodomésticos. Según Joshua You, el analista de datos de Epoch que realizó el análisis, para TechCrunch

El uso de energía realmente no es un gran problema en comparación con el uso de electrodomésticos normales o la calefacción o refrigeración de su hogar, o la conducción de un automóvil

Como hemos comentado anteriormente, el excesivo gasto de recursos naturales para el correcto funcionamiento de la inteligencia artificial es un debate abierto. La semana pasada, un grupo de más de 100 organizaciones publicó una carta abierta instando a la industria de la IA y a los reguladores a garantizar que los nuevos centros de datos no agoten los recursos naturales y obliguen a las empresas de servicios públicos a no depender de fuentes de energía no renovables.

Yu apunta a que el autor del informe, que llegó a la estimación de 3 vatios-hora, asumió que OpenAI usaba chips más antiguos y menos eficientes para ejecutar sus modelos. «He visto muchos discursos públicos que reconocían correctamente que la IA iba a consumir mucha energía en los próximos años, pero no describían con precisión la energía que iba a destinarse a la IA hoy. Además, algunos de mis colegas notaron que la estimación más difundida se basaba en una investigación bastante antigua«.

A pesar del reciente descubrimiento, You asegura que el consumo de ChatGPT aumentará en el futuro: «la IA se volverá más avanzada, entrenarla probablemente requerirá mucha más energía, y esta IA futura podrá usarse mucho más intensamente, manejando muchas más tareas, y tareas más complejas, que como la gente usa ChatGPT hoy».

El artículo Al fin buenas noticias para ChatGPT. Su consumo de energía parece no ser tan grande como parecía, o eso dicen los expertos fue publicado originalmente en Urban Tecno.

Dejar una contestacion